Chapitre 8

Survivances thermiques du Big

Bang

8.1 Recombinaison des photons et découplage

Un des moments les plus importants de l’univers primordial fut quand il devint transparent aux photons optiques. Ceci arriva quand les gaz neutres d’hydrogène et d’hélium purent se former, un gaz neutre étant transparent, par opposition à un plasma ionisé. Le rayonnement a pu commencer à se propager librement et aujourd’hui il continue à le faire à travers l’univers dans toutes les directions, simplement décalé en fréquence vers le domaine radio micro onde. C’est le RFC qui a été et demeure un témoignage important des quelques centaines de milliers d’années après le Big Bang. Dans ce chapitre nous allons étudier les autres témoignages du Big bang.

8.1.1 Asymétrie matière – antimatière

Après l’annihilation des électrons et des positrons (à des températures bien inférieures au MeV), le nombre de positrons dans l’univers devint très petit et comme ils devinrent non relativistes, leur nombre décrût encore exponentiellement. Cependant, il y eut un petit supplément d’électrons, juste assez pour équilibrer la charge électrique des protons. L’origine exacte de cette asymétrie entre matière et antimatière dans l’univers est toujours inexpliquée.

Cependant , dans les théories modernes de la physique des particules , plusieurs mécanismes qui créent cette asymétrie existent. Andrei Sakharov, le célèbre physicien russe a montré que pour obtenir cette asymétrie entre matière et antimatière, même à partir d’un état initial symétrique, il fallait nécessairement que trois conditions soient remplies.

- Il doit exister des interactions violant la symétrie CP. C est l’opérateur de conjugaison de charge et Pest l’opérateur de parité. Après la découverte de la violation P dans l’interaction faible (rappelons nous qu’au chapitre 6.2 , nous avons indiqué que seuls les neutrinos gauches semblent exister dans la nature), on se rendit compte que la transformation d’un état qui correspond à une particule, à celui qui correspond à une antiparticule, n’est pas seulement C, mais une action combinée CP. (Une transformation CP d’un neutrino gauche donne un antineutrino droit, qui existe aussi dans la nature. S’il n’y avait pas de violation CP, les particules et les antiparticules devraient se comporter de la même manière, et une asymétrie ne pourrait pas se produire. Dans le modèle standard la violation CP existe du fait d’interférences entre les trois familles de quarks et de leptons, deux familles n’auraient pas suffi. Dans le système du méson K0 (un état lié d’un quark d et d’un antiquark s) la violation CP a été découverte expérimentalement par Fitch et Cronin dans les années 60.

- Il doit exister des interactions violant le nombre baryonique. Aujourd’hui, il y aune asymétrie entre les baryons et les antibaryons (qui est que le² nombre de Baryons est supérieur au nombre d’antibaryons). Des interactions violant la loi de conservation du nombre de baryons ont du se produire. Dans les théories de grande unification (unification des interactions faibles, forte et électromagnétique) de telles violations sont prédites. Une prédiction, non encore vérifiée expérimentalement est que le proton doit se désintégrer spontanément. Sa période doit toutefois être supérieure à 10 33 ans pour être compatible avec les limites expérimentales constatées (âge supposé de l’univers 10 10 ans). Dans le modèle standard minimal, de telles violations du nombre baryonique devraient pouvoir également se produire. Ce sont les processus appelés instanton, non perturbatifs, découverts par G.’t Hoof. Aujourd’hui ils sont encore plus faibles que les processus de la GUT car ils ont à vaincre une barrière de potentiel énorme rendant improbable leur production par effet tunnel, mais dans l’univers primordial, l’énergie thermique énorme a du leur permettre de franchir cette barrière. C’est un domaine de recherche théorique très actif aujourd’hui, et toutes les implications n’ont pas encore été tirées au clair. Il semble que la violation CP présente dans le modèle standard minimum ne suffit pas à expliquer comment cela marche, mais il est peut être suffisant d’introduire un doublet de champs de Higgs supplémentaire, comme cela est requis dans les théories supersymétrique. Dans la plupart des modèles l’asymétrie des baryons est exactement compensée par l’asymétrie des leptons.

- Ecart à l’équilibre thermique. C’est nécessaire du fait de la symétrie CPT supposée exacte dans la nature ( T est l’opérateur de renversement du temps) , qui requiert que la masse des particules et des antiparticules soient exactement la même, et que les abondances des espèces de particules à l’équilibre thermique à une température constante ne dépend que de la masse. Dans le modèle du Big bang, ce n’est pas un problème, car nous avons constaté la décroissance continue en température qui a pour effet de faire quitter successivement l’équilibre thermique à toutes les espèces de particules. Comme nous le verrons, il suffit que l’asymétrie matière antimatière soit de l’ordre de 10 -10 pour être conforme aux observations.

8.1.2 La fraction ionisée- L’équation de Saha

Nous pouvons donc en première approximation incorporer l’asymétrie matière – antimatière en posant ne+ =0, np- = 0 et ne- = np+. Les électrons et les photons sont restés couplés jusqu’à ce que leur taux d’interaction tombe sous le taux d’expansion de l’univers. Le mécanisme de base de diffusion des photons de basse énergie sur les électrons est la diffusion Thomson, e- + γ à e- + γ , qui selon l’estimation (6.27) a une section efficace de :

Le taux d’interaction total par photon est alors (comme v = c = 1, pour les photons)

![]()

Et quand Гγ / H < 1, les photons se découplent. Ceci se produit à une température entre 1 et 10 eV.

Quand nous essayons de calculer ne, en fonction de la température un nouveau phénomène se produit. Les électrons peuvent disparaître en se combinant avec les protons pour donner des atomes d’hydrogène neutre plus des photons. L’hydrogène ainsi formé peut à nouveau être ionisé par les photons. Nous devons donc considérer des réactions du type p + e- <-> H + γ dans le plasma primordial. Ceci signifie que le potentiel chimique satisfait

![]()

A l’équilibre (les photons ont un potentiel chimique nul). Comme les baryons (protons) peuvent être soit libres soit liés dans un atome d’hydrogène, nous introduisons la densité totale de baryons nB

![]()

La neutralité de charge implique

![]()

Comme nous nous intéressons aux processus qui apparaissent à des températures inférieures à 10 eV (à comparer à l’énergie de liaison de l’atome d’hydrogène qui est de 13,6 eV), e, p, et H sont tous non relativistes en première approximation. Nous pouvons donc utiliser l’équation (7.20) dans les intégrales définissant ni pour trouver, dans la limite non relativiste :

![]()

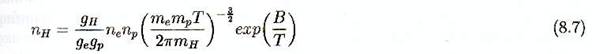

Pour i = e,p,H. En utilisant l’équation 8.3 et la relation mH = me +mp –B qui définit l’énergie de liaison B, nous pouvons résoudre pour trouver nH :

Ceci peut être encore simplifié en notant que ne = np et en première approximation mp/mH =1. En définissant la fraction ionisée Xe par :

Et le rapport baryon / photon par NB

On obtient

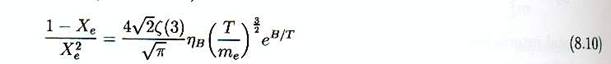

C’est ce qu’on appelle l’équation de SAHA pour la fraction ionisée à l’équilibre thermique. Elle peut être résolue pour exprimer Xe en fonction de T et donc en fonction du Redshift z (car T = 2.73 (1+z) K). Le rapport baryon / photon est relié à la contribution des baryons à la densité ΩB de l’univers par :

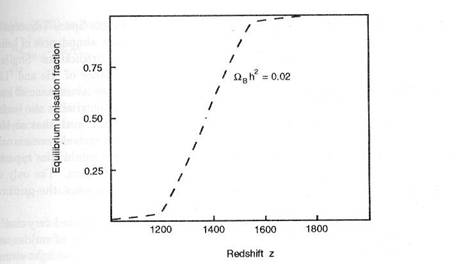

Nous verrons que la nucléosynthèse du Big Bang ( la synthèse des noyaux légers, hélium, deutérium et lithium) contraint NB dans l’intervalle (5-6 ).10-10, ce qui correspond à ΩB .h² # 0,02. Comme montré sur la figure 8.1 , la fraction ionisée tombe sous les 10% à un redshift de 1200-1300. Le processus de capture des électrons par les protons pour former de l’hydrogène est appelé recombinaison.

Nous venons de montrer que la recombinaison se produit à un redshift zrec de :

![]()

Ceci correspond à une température de recombinaison de :

![]()

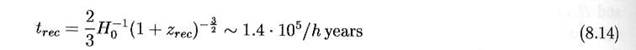

Et à un âge de l’univers à la recombinaison de :

Si Ω0 ≠ 1 , le membre de droite doit être divisé par √Ω0

Naïvement, nous aurions pu supposer que la recombinaison se produirait à environ T = 13 eV, qui correspond à l’énergie de liaison de l’atome d’hydrogène. Mais la distribution de Bose Einstein des photons contient une longue « queue » d’énergie supérieure à T. Donc, il faut que le taux de réaction p + e- <-> H + γ soit plus rapide que le taux d’expansion de Hubble. Nous verrons que cela se produit autour de Redshift de l’ordre de 1100. Après cela, l’équilibre ne peut plus être maintenu et la fraction ionisée est gelée à la valeur qu’elle avait autour de z = 1100.

Fig 8.1 : La fraction ionisée à l’équilibre en

fonction du redshift z, pour une valeur

ΩB .h² = 0,02

De même la densité numérique de photons par volume co-mobile est fixée et c’est cette population de photons redshiftés depuis cette époque que nous observons aujourd’hui en tant que rayonnement de fond cosmologique ( RFC).

L’ionisation résiduelle détermine le parcours libre moyen des photons après la recombinaison (car le mécanisme dominant est la diffusion Thomson), et on peut calculer que ce libre parcours moyen devient supérieur au rayon de l’univers observable à des redshifts inférieurs à 1050. La région autour de zrec #1100 est donc quelquefois appelée surface de dernière diffusion du rayonnement de fond cosmologique des photons.

8.2 Nucléosynthèse

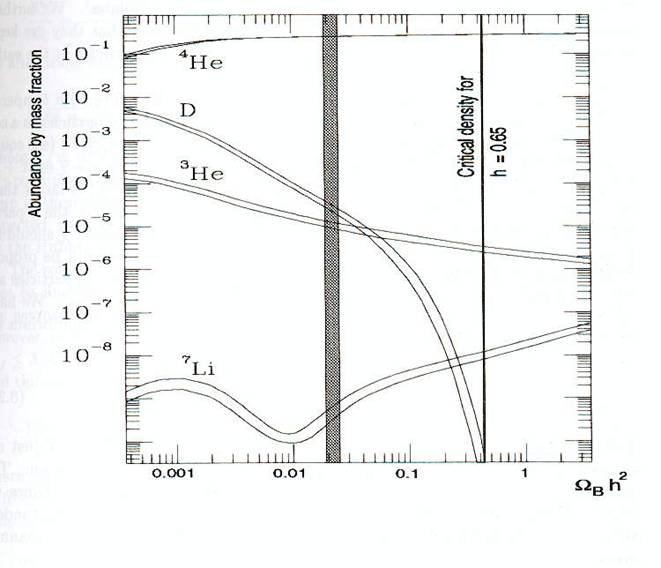

Une des pierres angulaires de la cosmologie du Big Bang est le fait que la fraction en masse de 4He est environ de 24 %, alors que l’hydrogène constitue le reste, à part des traces de 3He, 2H ( deutérium,D) et 7Li. Les autres éléments, communs dans notre environnement,ne constituent qu’une part infime de la matière baryonique de l’univers entier. L’opinion générale veut que les éléments plus lourds que le lithium aient été fabriqués dans les étoiles et dans d’autres processus astrophysiques (explosion de supernovae, rayons cosmiques,..). Cette opinion est confortée par de nombreux éléments. D’abord, la teneur en éléments lourds est cohérente avec les taux de formation des étoiles que l’on connaît et l’histoire de ces formations qu’on en déduit. Ensuite, la quantité importante d’Hélium ne peut pas s’expliquer par sa production stellaire. Des observations récentes ( par exemple par le télescope de Hubble HST) de nuages de gaz primordial à redshift élevé, montre que les abondances sont bien conformes aux prédictions du Big Bang.

De même, quand on observe de vieilles étoiles pauvres en métaux on trouve que l’abondance de l’Hélium4 et du Lithium 7, atteint des plateaux, qui est indépendante de l’abondance en éléments lourds. L’idée est que la production de l’Hélium 4 et du Li 7 par les étoiles s’accompagne inévitablement d’autres éléments plus lourds comme l’oxygène. ( en jargon d’astrophysicien, tout ce qui est plus lourd que le lithium est appelé « métal » et l’abondance associée métallicité). Si le lithium était fabriqué seulement dans les étoiles, on devrait constater sa décroissance avec la métallicité des étoiles observées. L’explication logique du plateau observé est qu’il représente l’abondance primordiale de ces éléments.

La nucléosynthèse est un champ de recherche bien maîtrisé, qui a été traité avec soin par des méthodes numériques, qui permettent de suivre la densité numérique des différents noyaux quelques secondes après le Big bang, au moment où les noyaux légers furent synthétisés. Un test, non trivial, et très important montre un accord remarquable entre les prédictions des calculs et les observations pour les quatre éléments légers, 4He, 3He,D et 7Li. Cet accord est réalisé sur une fenêtre étroite du rapport baryon/photon NB. Comme le nombre de photons est ultra majoritairement celui des photons du RFC déterminé par les observations, la limite supérieure de NB, pour la nucléosynthèse, donne une contribution maximum à ΩB ( en fait ΩBh² ) à la densité d’énergie totale de l’univers. Comme ceci est manifestement bien inférieur à ce qui serait nécessaire pour expliquer le comportement dynamique de l’univers, il nous incite à supposer que la majorité de la matière est « noire » c’est à dire non baryonique ( Le calcul de la densité de matière noire sera fait au chapitre suivant). Nous ne rentrerons pas dans le détail de la nucléosynthèse ici – les équations sont non linéaires et ne peuvent être résolues que numériquement. Cependant il n’est pas très difficile de brosser un tableau de la formation et de l’abondance de l’Hélium 4, élément le plus important ( hors hydrogène primordial, bien entendu)

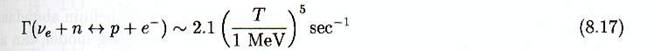

En ces temps reculés, ( t<< 1s) les neutrinos, électrons et positrons étaient toujours à l’équilibre à travers des réactions liées à l’interaction faible telles que :

Ces réactions sont le fait de l’interaction faible et correspondent à des sections efficaces de l’ordre de σ weak =α²s/m4W. Quand la température de l’univers était bien plus grande que la différence de masse entre le proton et le neutron Δm = mn – mp = 1,29 MeV,, les réactions étaient totalement réversibles. Quand la température est tombée en dessous de 1 MeV, la décroissance de la densité numérique de neutrons du fait de leur masse supérieure commença à devenir importante. Comme les protons et les neutrons étaient non relativistes à ces températures ( T ≈ 1 MeV << mn, mp ≈ 940 MeV), nous pouvons utiliser l’équation ( 5.20) pour calculer le rapport :

( Comme le nombre d’états d’hélicité gp = gn =2). Ceci montre qu’à haute température , le rapport valait pratiquement 1. Si l’équilibre avait été maintenu, le rapport n’aurait décru que faiblement à basse température. Cependant les calculs du découplage nous apprennent que ce qui détermine les abondances c’est souvent le gel de l’abondance du fait que le taux d’une réaction comme :

chute sous le taux d’expansion quand T < 0.8 MeV. Alors les neutrons ne sont plus détruits ( ou crées) par les deux dernières réactions de ( 8.15), mais continuent à être décimés par la désintégration de neutron ( première réaction). Donc cela est maintenant régi par le processus de désintégration du neutron, de période mesurée en laboratoire, plutôt longue, de 890 secondes environ. La densité numérique des neutrons est donc « gelée » à sa valeur autour d’une température de 0.8 MeV ce qui donne :

Avant de pouvoir se désintégrer la majorité des neutrons vont s’associer aux protons pour former des atomes d’hélium par l’une des chaînes de réactions

ou

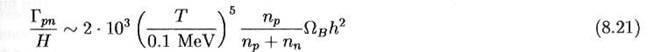

Le rapport du taux de réaction p+n <-> d + γ au taux d’expansion de l’univers est donné par

Ce qui est un rapport grand pour T >> 0.1 MeV. Comme la densité numérique des photons était très élevée, la photodésintégration du deutérium était très importante, et l’abondance du deutérium fut maintenue en dessous de 10-10 pendant l’équilibre.

Ceci a entraîné un taux très faible de réactions d+d , ( le taux est proportionnel au carré de l’abondance de deutérium , quelque chose de petit),en conséquence peu d’hélium fut produit pour T> 0.1 MeV. En dessous de cette température, la photodissociation devint inopérante, et l’abondance de deutérium crût jusqu’à 10-5 - 10-3, ce qui entraîna une fusion en hélium par la réaction d+d. Ceci consomma la majorité des neutrons, donc une bonne estimation de l’abondance 4He est donnée par

Rappelons que le rapport nn/np était de 0.2 pour T = 0.8 MeV. Après des neutrons se désintégrèrent, et le rapport à la fin de la nucléosynthèse ( T = 0.01 MeV) était d’environ 0.13. Ceci donne une abondance d’environ Y (4He) de 0.24, ce qu’on retrouve par un calcul plus exact. Ceci est exactement la valeur qu’on mesure dans les étoiles et les gaz pauvres en métal aux incertitudes de mesure près.

L’accord entre les calculs et l’observation de l’abondance d’hélium, conforte la théorie du Big Bang , mais peut aussi être utilisé pour contraindre les lois de la physique valides dans l’univers primordial. Un autre paramètre déterminant la valeur du taux d’hélium à la fin, est la décroissance du rapport neutron/proton due à la désintégration du neutron. Si l’expansion de l’univers avait été plus rapide que ce que le modèle standard indique, moins de neutrons se seraient désintégrés avant d’être stabilisés par leur capture dans les noyaux d’hélium, et l’abondance d’hélium serait supérieure. Comme selon l’équation de Friedmann le taux d’expansion H² α ρ et ρ est dominé par les espèces relativistes, d’éventuels neutrinos additionnels ( en plus des 3 familles du modèle standard) auraient accéléré l’expansion, provoquant un taux d’hélium en contradiction avec les observations. Cet argument fut utilisé, avant que le LEP au CERN ( Genève) arrive à la même conclusion et limite le nombre de familles d’abord à quatre maximum puis trois.

Le deutérium et 3He subsistent à l’état de traces ( gelées quand les réactions 8.19 et 8.20 sortirent de l’équilibre à des niveaux de 10-5 – 10-4. La mesure du deutérium s’est retrouvée d’actualité grâce aux observations de D.Tytler et de ses collaborateurs. Les Télescopes Keck et HST ont permis de détecter les raies d’absorption du deutérium à redshift élevé. La lumière des quasars , à l’occasion, traverse des nuages de gaz. S’agissant de redshifts élevés, on peut supposer que ces nuages reflètent l’abondance initiale ( du moins en donnent une borne minimum, car le deutérium est fragile, n’est pas produit mais ne peut être que détruit dans les étoiles). Le deutérium est donc un indicateur très sensible du rapport baryon/photon, du fait que la courbe dépend fortement de sa teneur et donc de ΩB h² ( voir fig 8.2). Les mesures actuelles donnent une valeur plutôt forte pour nB, correspondant à

![]()

Cependant, c’est encore loin de ce qui est nécessaire pour justifier les observations sur la densité de matière totale.

Une abondance de l’ordre de 10-10 – 10-9 est prédite pour 7Li à partir des réactions

![]()

Les éléments plus lourds ont été synthétisés en quantités négligeables, du fait qu’il n’y a pas d’élément stable avec A = 5 et A = 8 qui peuvent servir de relais. (Pour des noyaux à plus de 3 protons, la répulsion coulombienne est trop forte et prend le dessus sur les énergies thermiques au moment de la nucléosynthèse.

Fig 8.2 : Prédiction des abondances des éléments légers, par la nucléosynthèse associée au big bang, en fonction de ΩB h², qui est la contribution baryonique à la densité de matière actuelle. La bande verticale indique le résultat des mesures de l’abondance du deutérium primordial. Les abondances mesurées d’hélium et de lithium sont en accord avec celles définies par cette fourchette, compte tenu la marge d’incertitude des mesures. (Voir [35] pour plus de détails)

8.3 Gel et matière noire

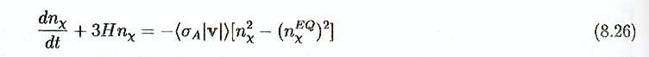

Avant de calculer la fraction ionisée gelée qui reste après le découplage des photons, il nous faut introduire un formalisme au sujet de ce gel en général : ce qui se passe quand une espèce de particule sort de l’équilibre. Un traitement rigoureux s’appuie sur l’équation de transport de Boltzmann, dans un cadre en expansion, mais nous donnerons ici une démonstration simplifiée (voir par exemple le livre par Kolb et Turner [23] pour une démonstration plus rigoureuse).

Nous devons d’abord considérer le cas hautement intéressant

de la matière noire. Supposons qu’il existe des espèces de particules χ

inconnues, avec l’antiparticule χ qui peuvent s’annihiler ou se

créer par paires par le processus χ + χ <-> X + X, où X est

une particule quelconque qui peut résulter de l’annihilation des χs.

[ Le neutralino supersymétrique est en fait sa propre antiparticule ,(comme le photon ). Le formalisme est très similaire dans ce cas. En particulier, un neutralino peut s’annihiler avec un autre neutralino pour donner d’autres particules non supersymétriques dans l’état final.]

Nous supposons que les particules χ ont un potentiel chimique nul et qu’elles étaient en équilibre thermique avec les photons et autres particules légères dans l’univers primordial (les particules X peuvent être des quarks , des leptons etc…).

Comment la densité numérique n χ de ces particules va

t’elle évoluer dans le temps (et par conséquent avec la température)? Il est

clair que dans un équilibre thermique exact le nombre de particules χ dans

un volume comobile N χ = a3 n χ sera donnée par la valeur

d’équilibre nχEQ (T), voir équation (7.16). (dans

un équilibre parfait , la réaction χ + χ <-> X + X a le même taux dans les deux sens). Si la

densité numérique réelle n χ (T) est plus importante que celle de

l’équilibre, la réaction va être plus importante vers la droite : les

particules χ vont plus s’annihiler

que se créer. Le taux de décroissance de χ

sera proportionnel à σ χ

+ χ -> X + X |v| n² χ ( quadratique

en densité car elle doit être proportionnelle au produit de n χ par n χ qui sont égaux). Cependant les particules

χ sont aussi crées par le processus

inverse, avec un taux proportionnel à (n χ EQ)². Nous avons établi l’équation de base qui régit l’écart à l’équilibre pour

les espèces χ

Le terme de gauche vient de 1/a3. d/dt( n χ a3),

le terme proportionnel à 3H ne

fait qu’exprimer la dilution liée à l’expansion de Hubble. L’expression σ χ

+ χ -> X + X |v| représente la section efficace moyenne thermique multipliée par la vitesse.

La moyenne est nécessaire, car les particules qui s’annihilent ont des vitesses

thermiques et des directions aléatoires.

En sommant sur tous les possibilités d’annihilation on obtient

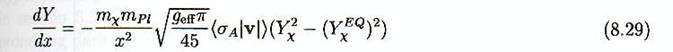

où σ A est la section efficace d’annihilation totale. En utilisant la relation temps température de l’équation (7.36) ( pour l’ère radiative)

Ceci peut être converti en une équation d’évolution pour n χ fonction de la température. Introduisons la variable sans dimension x =

mx/T et normalisons n χ à la densité d’entropie

Cela donne après quelques calculs

ou en réarrangeant

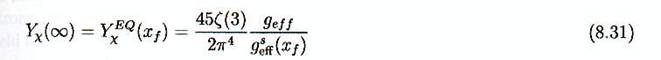

où ΓA = n χ EQ < σA |v|>. Cette équation peut être résolue numériquement avec la condition aux limites que pour x, Y χ ≈ Y χ EQ (comme à haute température les particules χ sont à l’équilibre avec les autres particules). De (8.30) nous déduisons, que comme escompté, l’évolution est pilotée par le facteur ΓA /H , le taux d’interaction divisé par le taux d’expansion de Hubble. Les solutions de ces équations s’obtiennent numériquement dans le cas général pour trouver la température Tf et donc la valeur de xf du gel et la valeur asymptotique à l’infini de Yχ et l’abondance résiduelle des espèces χ. Il y a cependant quelques cas simples. Si les espèces sont relativistes au moment du gel ( disons xf < 3), alors Y χ EQ ne change pas au cours du temps au moment du gel, et le résultat asymptotique Y χ infini est juste la valeur à l’équilibre au moment du gel.

ou geff = g pour les bosons et 3g/4 pour les fermions. Une particule qui était relativiste au moment du gel est appelée un fossile chaud. Un exemple typique est le neutrino. La densité de masse actuelle d’un fossile chaud de masse m vaut

Remarquons qu’aujourd’hui la vitesse d’une particule de

masse supérieure que la faible valeur T0 = 2.73K = 2.4 . 10-4 eV est bien entendu non relativiste et

donc la contribution à la densité d’énergie est dominée par l’énergie au repos.

Un neutrino ordinaire a un geff = 2.3/4 = 1.5 et se découple à

quelques MeV ( voir 7.55), quand geffs = 10.75. Si on impose que l’énergie des

neutrinos ne ferment pas l’univers, ( Ωνν

h²< 1 , ce qui peut aussi être une condition sur l’âge de l’univers, voir

section 4.5.1) , cela contraint la masse des neutrinos ( en fait la somme des

masses des 3 différentes familles de neutrinos de la nature).

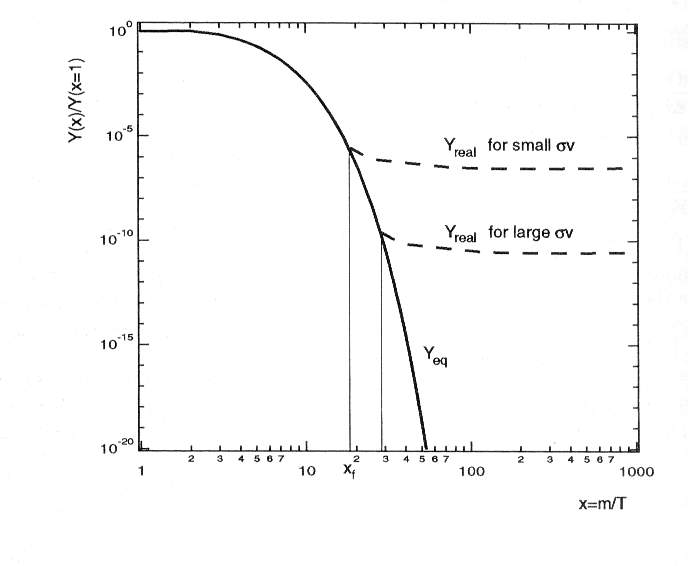

Cette analyse est valable pour les fossiles chauds (matière noire chaude HDM). Pour les fossiles froids (CDM) ( les particules non relativistes au moment du gel) l’équation (8.30) doit être résolue numériquement. Les solutions de cette équation sont données sur la figure 8.3 pour différentes valeurs de <σA |v|>

Figure 8.3 : Gel de particule massive. A une certaine valeur xf = mχ/Tf la densité numérique Y ( normalisée) à la densité d’entropie s et normalisée arbitrairement dans la figure à la valeur x=1 quitte la courbe d’abondance à l’équilibre Yeq ( ligne continue) et donne une abondance effective Y real montrée par la ligne interrompue. Comme on peut voir un taux d’annihilation plus élevé σv entraîne une abondance du fossile plus petite, car la courbe effective se raccorde à la courbe d’équilibre à plus basse température. Pour des particules massives faiblement interactives xf est de l’ordre de 20 . Adapté de [23]

Comme on peut le voir la valeur de xf ( quand Yχ quitte la courbe d’équilibre) est plus petit pour une valeur plus faible de σ A : Plus de particules faiblement interactives se découplent avant. Comme la courbe d’équilibre pour les espèces non relativistes chute rapidement avec x, ceci signifie que les particules les plus faiblement couplées doivent produire le fossile le plus important.

En appliquant numériquement, on voit qu’un neutrino hypothétique de masse mν = 3 GeV aurait la bonne masse pour fermer l’univers. D’autre part, la cosmologie interdit qu’un neutrino d’énergie dans l’intervalle 90eV-3 GeV soit stable. Il y a des arguments tirés de la formations des grandes structures qui privilégient le scénario CDM, et un tel neutrino serait un bon candidat de la matière noire. Les expérimentations faites par l’accélérateur LEP du CERN, ont exclu que le neutrino ordinaire puisse avoir une masse de l’ordre du GeV

Mais alors, qu’elle est donc cette matière noire ? Il apparaît qu’en physique des particules il y a des particules hypothétiques, comme les partenaires supersymétriques de nos particules bien connues, dont nous avons parlé au chapitre 6.9.1, qui ont la bonne force d’interaction et une gamme de masse adéquate pour en faire des candidats plausibles. En particulier le neutralino (équation (6.14) a bien les propriétés requises à une telle candidature. Comme il est électriquement neutre il n’émet pas ou n’absorbe pas de rayonnement ce qui fait qu’il est « noir » (Matière invisible serait un terme plus correct que matière noire). Les neutralinos se couplent par l’interaction faible, mais le grand nombre de possibilités de réactions d’annihilation, qui dépendent de paramètres inconnus de brisure de la supersymétrie rendent les prédictions sur sa masse et son abondance résiduelle assez incertaines. En balayant les paramètres d’espace, on voit cependant, qu’une masse du neutralino dans le fourchette 30 GeV- qq GeV doit donner une abondance résiduelle proche de la densité critique. C’est, actuellement, un domaine de recherche très actif et plusieurs expériences en cours dans le monde tentent de détecter de la matière noire supersymétrique , si elle existe.Un autre candidat pour la matière noire est l’axion, un boson hypothétique léger qui a été introduit pour des raisons théoriques pour expliquer l’absence de violation CP dans l’interaction forte ( Dans l’état des connaissances, seule l’interaction faible viole la symétrie CP). Il apparaît qu’avec une masse entre 10-6 et 10-3 eV , l’axion pourrait contribuer notablement à Ωm. Il se couple très faiblement à la matière ordinaire , mais il peut être converti en photon dans une cavité contenant un champ magnétique fort ( le couplage de base est avec deux photons, mais le champ magnétique joue le rôle d’un photon). Des expériences sont en cours aux USA et au Japon pour investiguer ce qui pourrait se trouver dans cet intervalle de masse.

Finalement nous pouvons retourner à la question du

découplage du photon : qui est la fraction ionisée qui a été gelée. En

comparant le formalisme χ + χ <-> X +X avec e + p <-> H + γ, nous

pouvons écrire l’équation de Boltzmann simplifiée pour ne :

![]()

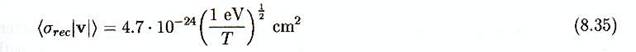

avec <σrec |v|> section efficace correspondant à la moyenne thermique à la recombinaison qui peut être calculée

En résolvant numériquement ( 8.34) on obtient

![]()

et la fraction d’ionisation résiduelle

![]()

Il est parfaitement plausible que cette valeur ait augmenté quand la première génération d’étoiles s’est formée, du fait du rayonnement hautement énergétique qui a ionisé le gaz primordial.

8.4 Résumé

L’asymétrie matière antimatière dans l’univers est de l’ordre de 10-10.

Bien que des mécanismes pour générer une telle asymétrie dans l’univers existent dans la théorie de physique des particules, une interprétation précise de son origine est toujours recherchée.

Les photons se sont découplés de l’équilibre thermique à un redshift d’environ 1300. Depuis cette époque de dernière diffusion ils ont été décalé vers le rouge et sont observés aujourd’hui dans le domaine micro onde, une pierre angulaire du big bang.

La nucléosynthèse s’est déroulée dans les premières minutes qui ont suivi le big bang. Les abondances observées d’hélium, deutérium et de lithium sont en accord avec les prédictions du big bang.

N’importe quelle particule neutre n’interagissant que via la force faible a pu être produite en grande quantité dans l’univers primordial et peut apporter une contribution non négligeable à la densité de matière aujourd’hui et expliquer peut être la matière noire.

Des neutrinos stables d’énergie comprise entre 90 eV et 3 GeV sont exclus, car en contradiction avec les modèles cosmologiques.